エッジ推論・学習向けの先進的省エネAIチップレット開発で、EdgeCortixがNEDOより新たに30億円のプロジェクトに採択

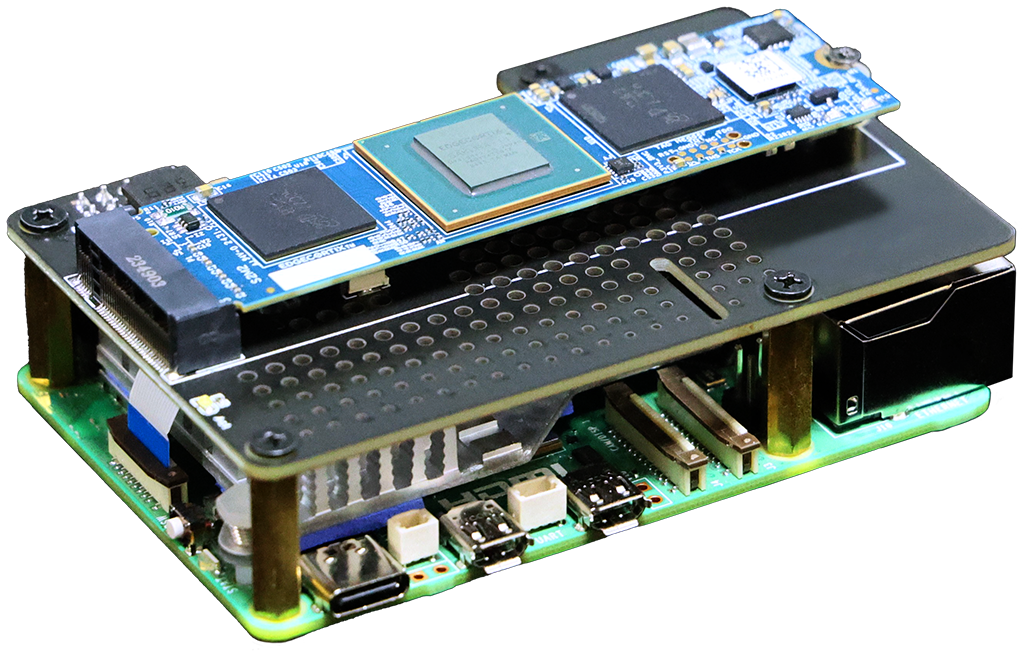

EdgeCortixの SAKURA-II AIアクセラレータ、Raspberry Pi 5および他のArmベースのプラットフォームに低消費電力の生成AIをもたらす

EdgeCortix、米国国防イノベーションユニット(DIU)契約を獲得した初の日本企業および半導体企業に

ispace、EdgeCortix社と月ミッションでの最新AI活用に向けた共同開発に合意

EdgeCortixの「SAKURA-II エッジAIアクセラレータ」が Electronic ProductsのデジタルIC部門で「the 2024 Product of the Year Awards」を受賞

エッジにおける生成系AIの次の波

世界で最も柔軟でエネルギー効率の高いAIアクセラレーター、

SAKURA-IIの紹介

沿革

EdgeCortixは、AIに特化したプロセッサー・アーキテクチャを一から設計しながら、ソフトウェア・ファーストのアプローチを適用するという斬新的なアイデアで2019年7月に設立されました。

当社の技術、強力なチーム、顧客第一の文化に支えられ、当社は世界をリードするファブレスAI半導体企業になることを目指しています。

当社のミッション

クラウドレベルに近い性能をエッジで実現し、エネルギー効率と処理速度を桁違いに高め、顧客の運用コストを大幅に削減する。

最新のニュース&イベント

「エッジでの情報処理における大きな変化を考慮すると、企業は今、データキュレーションとAIによる意思決定が一緒に行えるクラウドレベルに近いパフォーマンスを求めています。このような背景から、省電力でコストパフォーマンスの高いインテリジェントなソリューションを必要とするさまざまな分野の実用的なビジネスニーズが高まり、EdgeCortixのソリューションセットの市場機会はますます広がっています。データとデバイスの両方が世界的に急激に増加していることを考えると、既存のソリューションよりも桁外れに優れたエネルギー効率と低い総所有コストでパフォーマンスを実現できる業界をリードするIPポートフォリオを持ち、エッジAI市場に革新を起こしているEdgeCortixを今後サポートしていきたいと思います。」

ソフトバンクの先端技術研究所 所長である湧川隆次氏は、次のように述べています。「ネットワークインフラの性能向上と省電力化は、将来にかけて大きな課題です。EdgeCortixは、これらの課題を同時に解決するために必要なIPと技術に関する専門知識の両方を提供するパートナーとして期待しています。私たちは、今後も質が高いネットワークを提供するため、EdgeCortixと協力して、さらなる性能向上と省電力を実現する最適なアクセラレーターの研究を進めていきます」

「EdgeCortixは、市場において実にユニークなポジションにあります。主要な産業分野でAIアクセラレーションを活用した大規模なビジネスニーズに対応していることに加え、市場参入のためのソリューションをどのように開発するかというそのビジネス戦略が、大きな差別化要因となっています。半導体企業は少し近視眼的傾向があり、ほとんどの企業は、いかに素晴らしいソフトウエアのコードを提供するか、または、半導体のハード設計に注力しているかのどちらかです。しかし、EdgeCortixの特徴は、ソフトウェアとハードウェアIPの協調設計を行い、顧客のニーズに応じたソリューションを提供するというアプローチにあります。ソフトウェア中心のハードウェア・エコシステムで提供するこのアプローチこそが、同社の成長のキーであり、AIアクセラレーションの分野では他に類を見ない企業です。」

シリコンバレー・ジャパン・プラットフォーム エグゼクティブ・コミッティ・メンバー

「業界全体において、AI/機械学習のワークロードがかつてないほど増加する中、業界を牽引するIPプロバイダであるEdgeCortixと共に提供するソリューションは、当社のIntel Agilex FPGAベースの製品ポートフォリオを完全なものにします。当社の顧客は、現在だけでなく、将来の様々なビジネスニーズにおいて、リスクやコストを下げながら、パフォーマンスを向上させることができるという高い水準のAI推論ソリューションを求めていました。」

「多くのお客様がAI技術を含むアプリケーションソフトウェアを実装することが予想される ため、RZ/V MPUシリーズにMERAコンパイラと関連ツールセットを追加することに価値が あることをすぐに認識しました。お客様のニーズを満たすためにイノベーションを推進する 当社では、EdgeCortixと協力し、堅牢で高性能かつ柔軟なAI推論ソリューションを迅速にお 客様に提供します。EdgeCortixは素晴らしいパートナーであり、継続的な関係を築くこと で、我々とエンドユーザーに大きな価値をもたらすであろう今後の機会と可能性に期待して います。」