より多くのデバイスでエッジAI推論を実現するには?

ジェフリー H グロスマン

AI推論という言葉はよく耳にしますが、エッジAI推論とは一体何でしょうか?EdgeCortixは、ワークロード・効率・アプリケーションの観点から、その疑問にお答えします。

人工知能(AI)は、多くのアプリケーションのルールを変えつつあります。EdgeCortixのチームは、物体やパターンを認識するためのAIモデルのトレーニングを行い、入力されるデータストリームに対してそのモデルを使ってAI推論を実行します。サイズ、重量、電力、時間があまり問題にならない場合は、データセンターやクラウドベースのAI推論でもよいかもしれません。しかし、リソースに制約のあるエッジデバイスでは、異なるテクノロジーが必要です。より多くのデバイスでエッジAI推論を実現するには?エッジにおけるAI推論の違いとIPがどのように対応しているかを見ていきましょう。

CPUとGPUの非効率性を浮き彫りにするミスマッチなワークロード

ほとんどのAI推論は、ある種のニューラルネットワークのアーキテクチャに依存しています。根本的なレベルでは、ニューラルネットワークは積和演算方式であり、複数のレイヤにまたがる複数の並列構造のデータに対して一連の重み付け係数を付与する計算を実行します。

ごく単純なニューラルネットワークモデルでなければ、AI推論のワークロードと従来型のプロセッサコア、メモリ、インターコネクトでの処理とでは、根本的なミスマッチが存在します。汎用CPUでは並列での計算処理が不十分で、(AI推論の状況では)不要な演算のオーバーヘッドが大きすぎたりと、推論ワークロードに適していません。

GPUは、多数の小さなコアと構成可能なインターコネクトを備えているため、より適合性が高いのですが、それでもまだ、エッジコンピューティングのアプリケーションに対して大きな効率性の問題が2つあります。まず、高性能なGPUはリソースを大量に消費するため、十分なAC電源と強制空冷が必要ですが、エッジプラットフォームでは利用できないことが多々あります。また、AI推論タスクにおけるGPUハードウェアの使用率は低く、通常30~40%程度で、これは使える計算リソースの半分以上を捨てているようなものです。

実行ユニット、メモリ、インターコネクト間の複雑な相互作用により、1秒間にテラまたはペタ演算(TOPSまたはPOPS)で表される演算は、AI推論の効率についてほとんど意味をもちません。GPUをスケールアップして演算量を増やせば、推論性能の不足を解消できるかもしれませんが、それではより多くのリソースを消費するだけです。

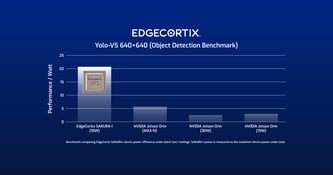

AI推論の効率をより適切に評価するには、スループットとエネルギー消費量を1つの指標で示す必要があります。IPS/W (Inferences per second per watt) は、比較を正規化し、AI推論IPの真のスケールを示します。EdgeCortixは、あるエッジAI推論のシナリオにおいて、GPUベースの構成に比べて16倍ものIPS/Wの効率向上が可能であることを実証しています。

AI向けのニューラルネットワークIPの論点に戻りましょう

どのようにして桁違いの効率化を実現しているのしょうか。ニューラルネットワークの推論IPを考える上で、3つのアーキテクチャパラメータに着目した結果が「効率化」です。

- 低レイテンシ: 多くのクラウドベースのアプリケーションとは異なり、エッジでは通常、レイテンシが最大の問題となります。エッジAI推論では、リアルタイムで入力されるデータストリームに対して、認識を行うためのウィンドウが固定されており、サンプルレートやフレームレートなどが制約されたり、これによって変化を見逃してしまったりするリスクがあります。また、推論は、一定の時間内に応答と制御を結論づけるようなウインドウで制御されたアルゴリズムで実行されることもあります。

- 高い使用率: ハードウェアをスリム化し、不要な部分を取り除くことは、効率化への第一歩となります。また、実行ユニットを常時稼働させる方法を見つけることも大切です。最大ワークロードに合わせて実行ユニットをスケーリングすると、負荷の少ない場合でもアイドル状態のユニットがスペースや電力などのリソースを消費してしまうことがあります。より効率的なアプローチは、適切なサイズの実行ユニットで、どのようなAI推論モデルでも、どのようなワークロードでも実行できるようにすることです。

- ランタイムで再構成可能: 特定のAI推論モデルに対してハードウェアの実行ユニットやインターコネクトを最適化すると、モデルが変更されたときに非効率的になることがよくあります。 一方、EdgeCortixが採用している、協調設計アプローチでは、アプリケーションのAI推論モデルを確認し、IP内のリソースと使用率に関する情報を用いてコンパイルし、ランタイムでそれぞれに応じてハードウェアを再構成することができます。

これらの要素をすべて考慮すると、ニューラルネットワークIPは、エッジでより多くのことを実現することができます。消費電力が少ないため、バッテリーの持ちが良くなり、より長い時間使用することができます。

新たな方法論は、リアルタイム・アプリケーションへの道を開きます。また、与えられたスペースに1ワット、1秒あたりの推論数を増やすことで、エッジデバイスはより複雑なAIモデルを処理できるようになり、効率の悪いアプローチでは不可能だった機能を実現することができるようになります。

エッジAI推論をより多くのフォームファクターで、より多くのアプリケーションに対応させる

より効率的で定義付けが可能なニューラルネットワークのIPについてはお分かりいただけたと思うので、本題に戻りましょう。「より多くのデバイスでエッジAI推論を実現するには?」

大まかに定義すると、エッジコンピューティングは、処理が行われる場所に近いところに、より多くの処理能力を備えます。どのような作業が必要で、どのようなSWaP(サイズ、重量、電力)が利用できるかが、フォームファクタの選択の決め手となります。

スケーラビリティとランタイムで再構成可能という特性を備えた、EdgeCortixのニューラルネットワークIPは、ハイエンドマイクロコントローラからFPGAアクセラレータカードにおけるシステムオンチップ設計に至るまで、さまざまな形態を取ることができます。EdgeCortixのソリューションは2つのコンポーネントから構成されています。1つ目はコンパイラおよびソフトウェアフレームワークであるMERA で、2つ目は、ランタイムで再構成可能なAI処理コアである Dynamic Neural Accelerator IP (DNA IP) です。 EdgeCortixは、この2つのコンポーネントを SAKURA SoCに実装し、デバイスの形態ですぐに使えるエッジAIチップとして提供しています。

エコシステム・パートナーの協力を得ることで、エッジAI推論は様々な形態に実装が可能です。FPGAアクセラレータカード は、 スマート・マニュファクチャリング や スマートシティのアプリケーション など、スペースや消費電力に余裕がある場合に、柔軟な実装を可能にします。SAKURAのSoCは、 防衛、 5G通信、ロボットやドローンのアプリケーション で、サイズや重量が懸念される場合、カスタムボード設計に適した、より小さなパッケージで推論を提供することができます。また、オートモーティブ・センシング のアプリケーション向けに設計されたカスタムSoCなど、よりカスタマイズ性の高い製品も選択肢の一つです。

もう一つの利点としては、EdgeCortixのテクノロジーを使えば、AIモデルの専門家がハードウェア実装の詳細を理解していなくても、効率的で高性能なエッジAI推論を扱えるということが挙げられます。GPU ベースの実装のみを扱ってきた研究者は、そのサイズから、大幅な再設計を行わない限りエッジデバイスに適用することができなかったことに対し、このテクノロジーは大いに受け入れられることでしょう。

EdgeCortixテクノロジーを活用するにあたって

現在、効率の悪いAI推論プラットフォームを使っている方でも、EdgeCortixの技術を簡単にお使い頂くことが可能です。MERAはGitHubのリポジトリからダウンロード可能です。また、すぐにお使い頂けるPCIeカードもあります。一つは、SAKURA SoCを搭載したEdgeCortixのカードで、もう一つは、Intel Agilex FPGAにビットストリームをロードしたAI推論パックを搭載したBittWare社のFPGA カードです

より多くのデバイスでエッジAI推論を実現するには?詳しく知るべき時代がきました。

ジェフリー H グロスマン

ジェフリーは、EdgeCortixのSVP(ビジネス開発および米国事業担当)です。EdgeCortix入社以前は、マーケティング、ブランディング、マネジメント、オペレーションなど様々な分野で30年以上の経験を培い、世界的な企業の急成長と大規模な変革を指揮してきました。 それ以前は、Determine Inc. (NASDAQ: DTRM) のCOOとして、Corcentricによる最終的な買収まで携わりました。また、同社のCOOを務めている間、グローバル企業の運営体制、事業計画、および分析を推進する役割を担っていました。Determine, Inc.以前は、Churchill Downs Incorp (NASDAQ: CHDN) に最終的に買収されたYoubet.com (NASDAQ: UBET) でCMROを務めていました。 Emory大学でMBAを取得し、Rutgers大学でコンピュータサイエンスと社会学を専攻しました。

関連記事